Environnement

Le 29-09-2015, traduit par B.Chalumeau Le 29-09-2015, traduit par B.Chalumeau Le moment est-il venu d'en finir avec la folie de gaspiller du temps et de l'argent sur de plus en plus de modèles climatiques ?

Auteur : Docteur Timoty BALL. Presque chaque modèle de prévision climatique, chaque projection, ou quelque soit le nom qu'ils lui donnent est erroné. Typiquement, les prévisions météorologiques au-delà de 72 heures se détériorent généralement à l'intérieur de leurs marges d'erreur. C'est ainsi que les prévisions de l'Office Météorologique britannique de l'été étaient fausses. Je ne mes souviens même plus du nombre de fois où ils se sont trompés. Ils ne font pas seulement des erreurs marginales. Sans arrêt, le temps qu'il fait est l'inverse de celui qu'ils avaient prévu. Les prévisions climatiques à court, moyen et long terme sont fausse dans plus de 50% du temps de sorte qu'une prévision correcte n'est pas autre chose qu'un événement aléatoire. Les prévisions mondiales et régionales sont elles aussi le plus souvent fausses. S'il existait un modèle de prévisions climatiques climat capable de prévisions justes dans 60% des cas, tout le monde l'utiliserait. Comme il n'existe pas de modèle de prévision climatique assez précis, le GIEC s'arrange pour faire la moyenne des prévisions de ses modèles, comme si, en quelque sorte, les erreurs s'annuleraient mutuellement de sorte que la moyenne des prévisions soit représentative de la réalité. Les prévisions climatiques à court terme ne valent pas mieux que celles de l'Almanach des anciens agriculteurs : Les modèles climatiques et leurs prévisions ont été des échecs complets qui auraient conduit à l'arrêt de leur utilisation dans toute autre entreprise. Sauf, bien sûr, dans le cas d'un fiasco financé par le gouvernement. Les prévisions météorologiques quotidiennes ont commencé à s'améliorer à partir de la première guerre mondiale. Toutefois, même les prévisions climatiques à court terme ne semblent pas meilleures que celles de l'Almanach des anciens agriculteurs apparu en 1792, qui utilisait la lune, le soleil, et d'autres indicateurs astronomiques et terrestres. « J'ai écrit et souvent parlé du rôle des modèles qui créent et perpétue le mythe catastrophique du réchauffement global anthropologique (AGW). Les gens ont été choqués par les courriels accablant de l'Unité de Recherche Climatique (CRU), mais la majorité ignore que les instructions pour "masquer la baisse" dans la partie de la crosse de hockey issue des anneaux de croissance des arbres sont dans le code informatique. C'est l'une des raisons qui fait que les gens assimilent les fluctuations à l'entrée ou à la sortie du modèle climatique informatique à un acronyme évangélique ».

Je suis fatigué de ces perpétuelles affirmations selon lesquelles les modèles climatiques peuvent fournir des prévisions correctes dans un système chaotique. La vérité c'est que les modèles climatiques ne fonctionnent pas et ne peuvent pas fonctionner correctement pour de nombreuses raisons, y compris les plus fondamentales : le manque de données, le manque de connaissance des processus physiques de base, l'incapacité des modèles climatiques à traduire fidèlement en formules mathématiques les phénomènes physiques comme la turbulence de l'air ainsi que l'insuffisance de capacité des ordinateurs.

Bob Tisdale a résumé ces problèmes dans son livre publié en 2013 « L'échec des modèles de prévisions climatiques ». Le moment est venu de cesser de gaspiller de l'argent et de perdre du temps dans ce domaine et d'affecter les chercheurs et les ordinateurs à des tâches plus importantes.

La seule chose qui pousse les gens à travailler sur les modèles de prévisions climatiques est le financement gouvernemental dans les bureaux de la météo ou à l'université. Sans ce financement, le GIEC n'existerait pas. Bien des gens impliqués dans la modélisation du climat n'ont aucune connaissance ni aucune formation en climatologie ou en science du climat. C'était des diplômés en programmation informatique à la recherche d'opportunités d'accès à de très hauts budgets et à de puissants ordinateurs.

Quand l'atmosphère et plus tard les océans étaient étudiés séparément, ça pouvait se concevoir. Mais maintenant qu'ils ont mis les deux ensembles on abouti au fiasco. Malheureusement cela fait supporter des charges énormes aux contribuables. Ces charges incluent non seulement les ordinateurs et les nombreuses heures de modélisation, mais aussi le coût pharaonique de l'application de résultats faux pour l'organisation mondiale de la gestion de l'énergie et pour la préservation de notre environnement.

Arrêtons ces simagrées et toute cette perte de temps et d'argent. Coupons tous les financements et plus personne ne dépensera l'argent des contribuables à travailler sur des modèles de prévisions climatiques.

Il m'est arrivé de prétendre qu'il pouvait y avoir quelque gain à s'amuser a concevoir des modèles de prévision climatiques en laboratoire avec un seul scientifique responsable de la précision, de la faisabilité et de l'applicabilité. Mais il est clair qu'ils n'atteignent pas leurs objectifs. Aussi, maintenant je me rends compte que cette proposition est mauvaise. Quand les résultats des modèles climatiques sont utilisés pour forger les politiques gouvernementales, il n'y a aucun gain. Par contre, il y a un coût phénoménal à la charge de la société en pure perte, correspondant aux frais de fonctionnement du GIEC, tout spécialement prévu pour empocher cet argent.

Le GIEC a toutefois un petit avantage. Il démontre la réalité des dysfonctionnements exposés dans les commentaires ci-dessus. Les modèles de prévisions climatiques sont manipulés dès leur sortie des laboratoires en dehors de toute rigueur scientifique dans les bureaux de la météorologie nationale ou à l'université, et deviennent ainsi les fondements des décisions politiques des hauts responsables des états à travers les rapports qu'ils reçoivent.

Un autre avantage des rapports du GIEC est qu'ils fournissent une liste détaillée des raisons pour lesquelles les modèles ne peuvent pas fonctionner et ne le pourront pas. Dommage que peu de gens les lisent ou cherchent à les comprendre. S'ils le faisaient, ils découvriraient les contraintes qui interdisent toute chance de succès. Juste un examen partiel le démontre.

Données :

Les gens du GIEC connaissaient les limites de données initiales dès le début, mais cela ne les empêcha pas de poursuivre la construction des modèles de prévisions climatiques.

En 1993, Stephen Schneider, un des promoteurs de l'hypothèse du réchauffement climatique d'origine anthropique et de l'utilisation de modèles passa du doute à la certitude quand il déclara :

« L'importance de l'incertitude pesant sur les résultats en retour de ces mécanismes est une raison pour laquelle l'objectif ultime de la modélisation climatique – la prévision fiable des variables clefs telles que les températures et les précipitations – est irréalisable ».

Un rapport du 3 février, 1999 Conseil national de recherches des Etats-Unis d'Amérique déclare :

« Les lacunes dans l'exactitude, la qualité et le suivi des enregistrements font naître des doutes importants quand à la confiance que l'on peut attribuer aux résultats de ces recherches ».

Ce à quoi Kevin Trenberth répondit :

« Il est tout à fait clair que nous ne disposons pas d'un système d'observation climatique fiable … .Ca pourrait provoquer un choc pour beaucoup de gens persuadés que nous savons de manière adéquate ce qui se passe avec le climat, alors que non ».

Deux directeurs du CRU, Tom Wigley, and Phil Jones dirent :

« Un très grand nombre d'incertitudes entourant les causes du changement climatique ne seront jamais levées parce que les données nécessaires manquent ».

70% de la surface du globe est couverte par des océans quasiment dépourvue de stations de relevés météorologiques.

Les pôles sont des zones essentielles dans la dynamique de la circulation atmosphérique et dans la création du climat et il n'y a encore quasiment aucune station météorologique dans 15 millions de km2 de l'océan Arctique ni dans les 14 millions de km2 de l'Antarctique. Environ 85% de la surface ne dispose d'aucune donnée météorologique. Le GIEC reconnaît ces limites en affirmant que les relevés d'une seule station sont représentatifs des conditions régnant dans un rayon de 1200 km. Est-ce une hypothèse valable? Je ne le pense pas.

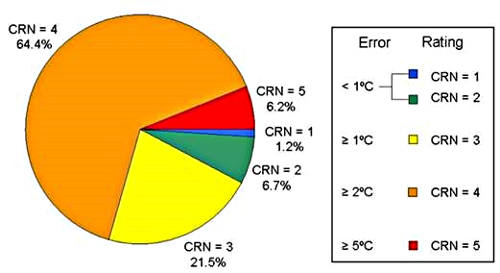

Mais ce n'est pas seulement un manque de données climatiques à la surface du globe. En fait il ne s'agit pas de données climatiques en surface, mais pour une gamme d'altitudes au dessus de la surface entre 1,25 et 2 mètres et comme les chercheurs depuis Geiger (Le Climat près du sol) on montré qu'elles sont nettement différentes des températures vraies mesurées par les quelques stations microclimatiques existantes. On peut prétendre que les stations météorologiques américaines sont les meilleures, mais l'étude produite par Anthony Watts montre que seulement 7,9% des stations météorologiques ont une précision de moins de 1%. (Figure 1). Pour mettre cela en perspective, dans le rapport du GIEC de 2001, Jones déclara qu'une augmentation de 0,6 °C sur 120 ans était au dessus des valeurs naturelles. Ceci souligne le fait que la plupart des températures enregistrées sont mesurées à 0,5°C près.

Figure 1

Les autres données de base telles que les précipitations, la pression barométrique, la vitesse et la direction du vent sont encore plus fausses que les données des températures. Par exemple, dans toute l'Afrique il y a seulement 1152 stations météorologiques qui ne représentent qu'un huitième de la densité minimale requise par l'Organisation Météorologique Mondiale (ONM). Comme je l'ao mentionné dans un précédent article, le manque de données pour toutes les phases du cycle de l'eau garantit l'échec des prévisions du GIEC.

Les modèles de prévisions météorologiques cherchent à simuler une atmosphère en trois dimensions, mais il n'y a pratiquement aucune mesure faite au dessus de la surface. Les producteurs de modèles pensent que nous sommes assez stupides pour croire l'argument selon lequel l'existence de plusieurs niveaux dans le modèle va résoudre le problème, mais c'est illusoire puisque nous n'avons pas les mesures correspondantes.

Les mécanismes principaux :

Pendant ma carrière de climatologue, plusieurs mécanismes météorologiques et climatiques ont été découvert ou mesurés, soi-disant avec une précision suffisante pour une application dans un modèle. Ceux-ci comprennent, El Nino / La Nina (ENSO), l'Oscillation Décennale du Pacifique (ODP), l'Oscillation Multidecennale Atlantique(OMA), l'oscillation antarctique (OAA), l'Oscillation Nord-Atlantique (ONA), la Dansgaard-Oeschger Oscillation (DO), l'Oscillation Madden-Julian (OMJ), le Dipôle de l'Océan Indien dipôle (DOI), entre autres.

L'effet Milankovitch non inclus dans les modèles du GIEC :

Malgré cela, nous maîtrisons mal les mécanismes associés à la cellule de Hadley et à la Zone de Convergence Inter-Tropicale (ZCIT), qui sont représentatifs de l'ensemble des mécanismes du climat tropical. L'effet Milankovitch reste controversé et n'est pas pris en compte dans les modèles du GIEC. La théorie cosmique semble apporter une réponse à la relation entre les taches solaires, la température mondiale, et les précipitations, mais elle est ignorée elle aussi par le GIEC. Ils ne traitent pas avec le mécanisme de la mousson bien qu'ils mentionnent :

« En bref, la plupart des modèles ne simulent pas avec précision la variation spatiale ou intra-saisonnière des précipitations des mousson ».

Il y a une connaissance très limitée des principales circulations océaniques en surface et dans les profondeurs. Il n'y a pratiquement aucune mesure des quantités de chaleur transférée ou de leurs évolutions dans le temps, y compris les mesures de chaleur géothermique.

Mécanismes physiques :

Le GIEC reconnaît que :

« Dans la recherche et la modélisation climatiques, nous devons reconnaître que nous avons affaire à un système chaotique non linéaire couplé, et donc que la prédiction à long terme des futurs états climat n'est pas possible ».

Cette prise de position suffit pour plaider en faveur de l'arrêt de cette perte de temps et d'argent. Elle se trouve confirmée par le second cas traité par Essex et McKitrick dans leur rapport « Pris par la tempète »

La recherche climatique est tout sauf une application systématique des théories classiques comme la mécanique des fluides par exemple, même si certains peuvent être tentés de le penser. Elle doit être classée en partie dans la catégorie des problèmes scientifiques « exotiques », parce que nous nous efforçons à chercher une structure scientifiquement crédible que personne ne peut voir ou n'a jamais vu, et qui peut même ne pas exister.

« À cet égard, il est essentiel de garder à l'esprit qu'il n'existe pas de station expérimentale pour le climat mondial, de sorte que nous en sommes aux principes élémentaires de base ce cette connaissance. Vous pouvez faire toutes les mesures que vous voulez, remplir des téraoctets d'espace disque si vous voulez, mais ça ne vaut rien comme moyen d'essai expérimental. Des appareils sophistiqués peuvent être mis en oeuvre et ceux qui les pilotent peuvent faire des mesures sur toutes les variables connues sur une gamme de conditions physiques associées. En revanche nous devons seulement échantillonner le climat quotidien à condition que nous soyons assez lucides pour seulement comprendre comment faire la moyenne d'une petite quantité de données d'une manière suffisamment significative pour représenter le climat. En bref, le climat mondial est pas traitable par tous moyens classiques ».

Capacité des ordinateurs :

Les concepteurs de modèles de prévisions climatiques prétendent que les ordinateurs s'améliorent sans cesse et qu'il leur faut toujours des ordinateurs plus gros et plus rapides. Ca ne les émeut pas et ils continuent à gaspiller l'argent. En 2012, la société Cray produisit le supercalculateur baptisé GEA (Figure 2). Il a une capacité de 1,1 petaflops. (FLOPS veut dire Opérations en virgules flottantes Par Seconde, et PETA signifie 1015 ou le milliard de millions d'opérations en virgule flottante par seconde). Jagadish Shukla dit que le défi est :

« Nous devons être en mesure d'exécuter les modèles climatiques à la même résolution que les modèles de prévision du temps, ce qui peut avoir des résolutions horizontales de 3-5 km dans les 5 prochaines années. Cela nécessitera des ordinateurs avec une capacité maximale d'environ 100 petaflops ».

Quelle que soit la puissance de l'ordinateur, il est sans signification tant qu'on n'y introduit pas les valeurs exactes du modèle.

Figure 2: Super calculateur Cray Gaea avec image environnementale.

Mauvaises prévisions (prédictions, projections) :

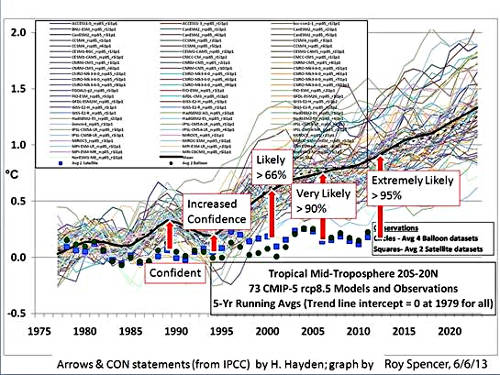

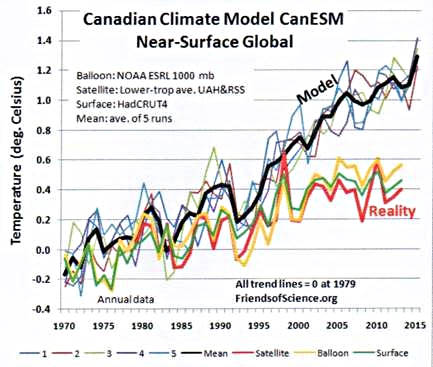

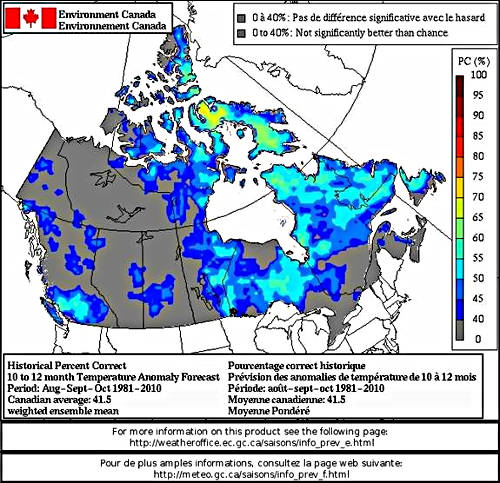

La figure 3 montre les prévisions fausses du GIEC. Ils les appellent des projections, mais le public croit que ce sont des prévisions. Quoi qu'il en soit, elles sont toujours fausses. Remarquez les étiquettes ajoutées au graphe de Hayden tirées du sommaire à l'attention des décideurs politiques. Comme la marge d'erreur augmente dans les données réelles du sommaire, le GIEC prétend que la précision s'améliore. Un des modèles informatiques utilisés pour les prévisions du GIEC appartient à Environnement Canada. Leurs prévisions sont les pires de tous ces résultats moyens utilisés par le GIEC (Figure 4).

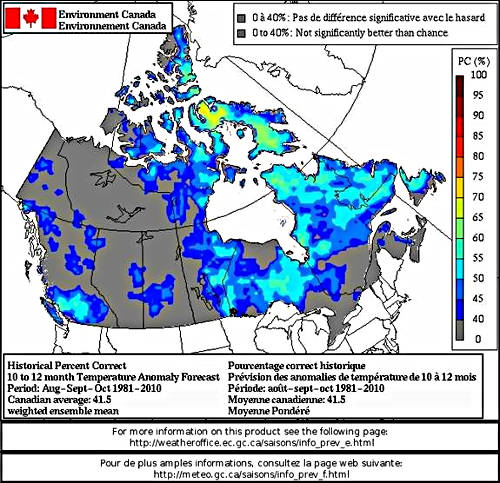

La catastrophe canadienne n'est pas surprenante comme l'indique leur prévision à un an l'indique. Ils font une prévision annuelle et fournissent une carte indiquant le pourcentage de précision par rapport à la moyenne pour la période 1981 à 2010 (figure 5).

Figure 5

Le pourcentage moyen de précision pour le Canada est indiqué en bas à gauche pour 41,5 pour cent. Voilà la meilleure valeur qu'ils peuvent atteindre après quelques trente années de développement des modèles de prévisions climatiques ! Pour les autres pays du globe, les résultats ne sont pas meilleurs.

Dans un rapport du « New Scientist », Tim Palmer, l'un des principaux modélisateur du climat au Centre européen de prévision météorologique à moyen terme de Reading England a dit:

« Je ne veux pas torpiller le GIEC, mais ses prévisions, en particulier pour les changements climatiques régionaux, sont extrêmement incertains ».

Le coût du GIEC : "La somme actuellement dépenséedoit être bien supérieure à 100 milliards de dollars" :

Joanne Nova a fait la plupart des recherches sur le coût de la recherche climatique pour le gouvernement américain.

« Au total, au cours des 20 dernières années, à la fin de l'exercice 2009, le gouvernement américain leur aura versé 32 milliards de dollars pour la recherche sur le climat et 36 autres milliards pour le développement des technologies liées au climat. Ce sont des dollars constants, obtenus à partir des rapports du gouvernement, et non ajustées pour tenir compte de l'inflation. Ils ne prennent pas en compte les financements obtenus d'autres gouvernements. Le total réel final ne peut qu'être supérieur et grossir encore ».

Il ne fait aucun doute que cette valeur a augmenté, et le total mondial est susceptible de doubler le montant des États-Unis que le commentateur ci-dessus a déclaré.

« Cependant, je peux ajouter au moins un demi milliard de livres aux 79 milliards de dollars déclarés par Joanne Nova, auxquels il convient d'ajouter 1,9 milliards d'euros du programme cadre de l'Union Européenne (UE 7) pour la recherche sur le changement climatique direct. Le programme Cadre 6 est de l'ordre de 769 Millions d'euros. Si nous prenons en compte tous les pays de l'Annexe 1, la somme dépensée actuellement doit être bien supérieure à 100 milliards de dollars $».

Ces coûts ne représentent que le coût de la modélisation informatique. Les coûts économiques et sociaux sont beaucoup plus élevés et pratiquement impossible à calculer. Comme l'explique Paul Driessen :

« Comme pour ses homologues polaires, 90% de l'iceberg du financement du Titanic-Climatique est absolument invisible pour la plupart des citoyens, des hommes d'affaires et des politiciens ».

Il n'est pas étonnant que Larry Bell put dire :

« Le Government Accounting Office (GAO) américain ne peut pas comprendre quels avantages les contribuables reçoivent de tous ces milliards de dollars dépensés chaque année pour des études visant prétendument à lutter contre le changement climatique ».

S'il est impossible pour un organisme supposé sophistiqué comme le GAO américain pour déterminer les coûts, alors il n'y a aucun espoir pour obtenir un jour une évaluation pour l'ensemble de la planète. On peut donc penser sans trop se tromper que le coût direct se mesure enmilliers de milliards dedollars. Cela ne comprend pas les occasions perdues pour le développement et la vie continue dans la pauvreté. Tout cela à cause des résultats falsifiés de prédictions, de projections, ou autres noms, issues de modèles informatiques totalement défaillants

N'est-il pas temps d'arrêter la folie, qui, dans la science du climat, consiste à créer sans cesse, encore et encore des modèles informatiques qui ne fonctionnent pas et ne fonctionneront jamais ?

Pour ma part, je pense que oui !

« Ceux qui ont le savoir ne font pas de prédictions. Ceux qui font des prédictions n'ont pas le savoir »

Lao Tzu, 6ème siècle avant JC

Site du Dr Ball : http://drtimball.com/Carrière : 1996 à maintenant - Environnementaliste, Conférencier, consultant, auteur, chroniqueur. 1988-1996 Professeur, Université de Winnipeg 1984-1988 professeur agrégé, Université de Winnipeg De 1982 à 1984 Professeur adjoint, Université de Winnipeg 1977-1978 doyen intérimaire des étudiants 1972-1982 Maître de conférences, Département de géographie, Université de Winnipeg De 1971 à 1972 Instructeur, Département de Géographie, Université de Winnipeg Dr Ball est l'auteur de plus de 80 publications importantes. Voir la liste ici: http://drtimball.com/_files/dr-tim-ball-CV.pdf

WUWT

Suite...  Lien permanent

|

Chargement de l'article...

Chargement de l'article...

Chargement de l'article...

Chargement de l'article...

Chargement de l'article...

Chargement de l'article...

|

Le 29-09-2015, traduit par B.Chalumeau

Le 29-09-2015, traduit par B.Chalumeau